La imagen del periodista Enrique Acevedo, conductor del noticiero En Punto de N+ —una división de TelevisaUnivision— ha sido utilizada sin su autorización en varios videos que circulan en TikTok sobre migración en Estados Unidos, donde se le ve aparentemente informando noticias que en realidad no ha reportado. Acevedo desmintió la veracidad de esas grabaciones, y confirmó a elDetector que estos contenidos fueron generados con inteligencia artificial (IA).

Esos videos en TikTok sobre migrantes NO fueron reportados por Enrique Acevedo: suplantan su identidad

El periodista se suma a la lista de víctimas de suplantación de identidad que elDetector ha verificado: casos en los que imágenes y voces son alteradas digitalmente. En Estados Unidos, se reportaron más de un millón de estos casos en 2024.

En uno de los videos publicados en TikTok, se escucha supuestamente al periodista diciendo: “Escándalo histórico en Estados Unidos. General del Ejército desafía a [el presidente Donald] Trump y paraliza las deportaciones en todo el país”. Esta afirmación fue ya desmentida en su momento por elDetector. En otra grabación, se lanza una supuesta alerta a la “comunidad inmigrante en Florida” sobre una presunta ley que prohibiría estar en la calle después de las 10 de la noche.

¿Quieres verificar algo? Envíalo a nuestro chat de WhatsApp +1 (305) 447-2910 o pincha aquí:

Suplantan su identidad

Acevedo desmintió ser la fuente de los videos en los que supuestamente aparece anunciando medidas relacionadas con la comunidad migrante.“Te confirmo que son contenidos generados con IA para los que no autoricé el uso de mi voz y mi imagen”, dijo el periodista a elDetector en respuesta a nuestra consulta enviada vía correo electrónico.

Añadió que este tipo de suplantaciones “ocurre con cierta frecuencia y cada vez con un mayor grado de sofisticación”.

Estos clips no fueron publicados desde la cuenta oficial de Acevedo, ni por el medio de comunicación al que pertenece, sino que comenzaron a circular a través de cuentas de usuarios en redes sociales.

Días antes, a través de su cuenta oficial en X (antes Twitter), Acevedo ya había denunciado públicamente el uso no autorizado de su imagen.

“No es real. Es un contenido generado con inteligencia artificial, diseñado para confundir y desinformar”, escribió el 9 de junio de 2025 en referencia a un video en el que supuestamente se le escucha decir que el vicepresidente J.D. Vance “exige la destitución de Trump” por “abuso de poder”.

Desde elDetector, además, utilizamos la herramienta DeepFake-O-Meter, desarrollada por el Media Forensic Lab de la Universidad de Buffalo, para analizar el audio de los clips. El sistema detectó una probabilidad del uso de inteligencia artificial superior al 78% en uno de los casos y del 90% en el otro.

Con el avance de la tecnología, es posible replicar “rostros, expresiones e incluso patrones de voz” en los que “el resultado es tan convincente, que muchas veces es casi imposible diferenciar entre lo real y lo manipulado”, señala la Universidad Galileo de Guatemala sobre los riesgos del uso de IA.

Los presentadores, objetos de desinformación

En elDetector hemos verificado varios casos en los que se utiliza sin autorización la imagen y la voz de reconocidos periodistas y presentadores de Univision Noticias para difundir desinformación o promocionar productos que no respaldan. Entre los afectados figuran Ilia Calderón, Borja Voces, entre otros.

En 2024, la imagen de Ilia Calderón, presentadora del Noticiero Univision, apareció en un video donde supuestamente anunciaba que “a los hispanos se les borrarán sus deudas”. Aunque el contenido mostraba su imagen real, el audio había sido manipulado. En el caso de Borja Voces, su imagen fue utilizada para promover un presunto “método innovador” para tratar la diabetes. El video, compartido en redes sociales, también fue alterado digitalmente.

Este tipo de prácticas se da en un contexto de creciente suplantación de identidad. En 2024, en Estados Unidos se reportaron “más de 1.1 millones de casos”, según datos de la Comisión Federal de Comercio (FTC, por sus siglas en inglés). Los ciberdelincuentes, en ocasiones, recurren al uso no autorizado de la imagen de figuras públicas para atraer mayor número de visualizaciones, lo que puede traducirse en ingresos monetarios a través de plataformas digitales.

Conclusión

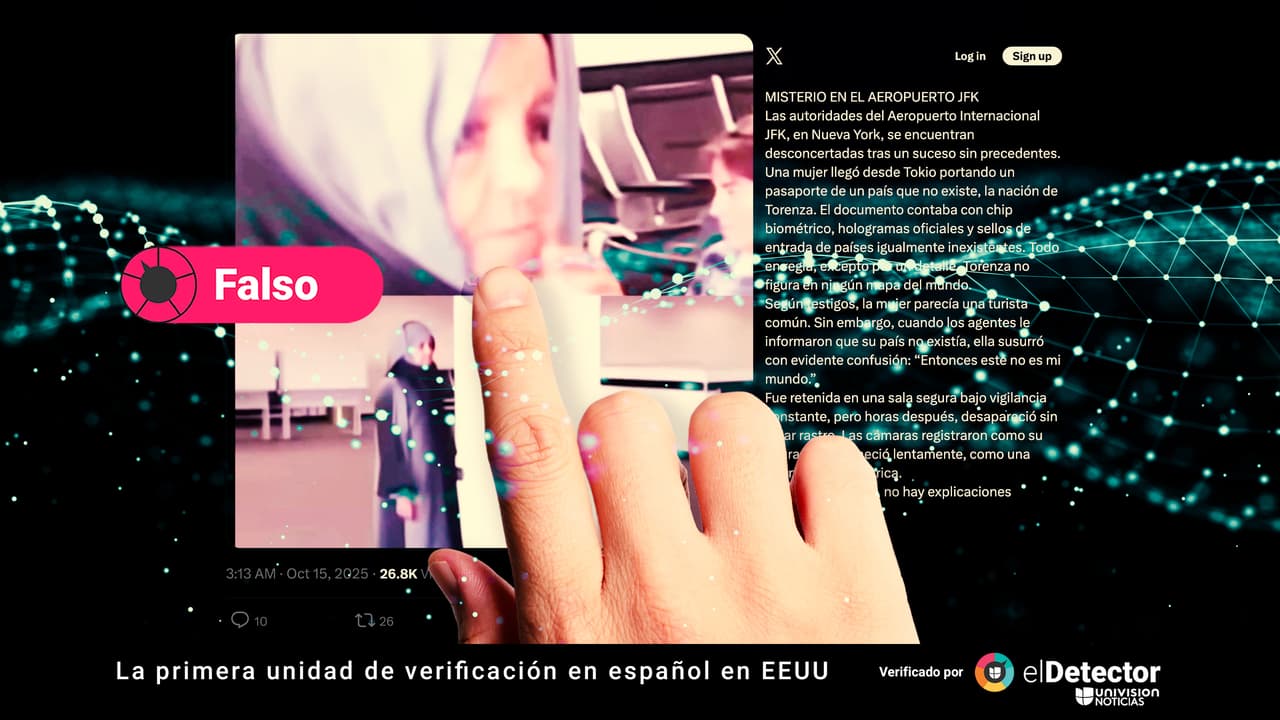

Es falso que la voz del periodista Enrique Acevedo sea la que se escucha reportando sobre supuestas medidas que afectan a la comunidad migrante, como se ha difundido en redes sociales. El propio Acevedo desmintió esta información a elDetector: “Te confirmo que son contenidos generados con IA para los que no autoricé el uso de mi voz y mi imagen”. Antes, denunció públicamente mediante su cuenta de X el uso no autorizado de su imagen con fines de desinformación. Un análisis realizado con una herramienta de la Universidad de Buffalo determinó también que los audios tienen una probabilidad de entre el 78% y el 90% de haber sido generados mediante inteligencia artificial. Lee aquí cómo escogemos y asignamos nuestras etiquetas en elDetector.

elDetector opera de forma independiente con el financiamiento de instituciones que puedes ver aquí y que no tienen ningún poder de decisión sobre nuestro contenido. Nuestra línea editorial es autónoma.

¿Viste algún error o imprecisión? Escríbenos a eldetector@univision.net o a través de nuestra cuenta de X (Twitter) @eldetectoruni. Tras verificar tu solicitud, haremos la corrección que corresponda en un plazo no mayor de 48 horas.

Lee aquí nuestra metodología y política de corrección. Seguimos el Código de Principios de la International Fact-Checking Network (IFCN), que puedes ver aquí traducido al español. Escribe a la IFCN llenando este formulario si consideras que no estamos cumpliendo ese código.

Envíanos al chat de WhatsApp +1 (305) 447-2910 lo que quieras que verifiquemos :