Un joven con suéter negro con capucha está parado frente a un soldado de uniforme camuflado y casco; el joven grita en la cara al militar, en inglés: “¿Cuál es tu nombre? ¿Cuál es tu nombre, soldado? Dime tu nombre. ¿No me estás escuchando? ¿Cuál es tu nombre?”, a lo que el militar responde con un lanzamiento de gas pimienta color naranja, y dice “Sargento Pimienta”. El video ha circulado en decenas de publicaciones en redes sociales desde que el gobierno federal desplegó la Guardia Nacional en Chicago.

El caso del “Sargento Pimienta” y la hiperrealidad que la app Sora 2 aporta a la desinformación

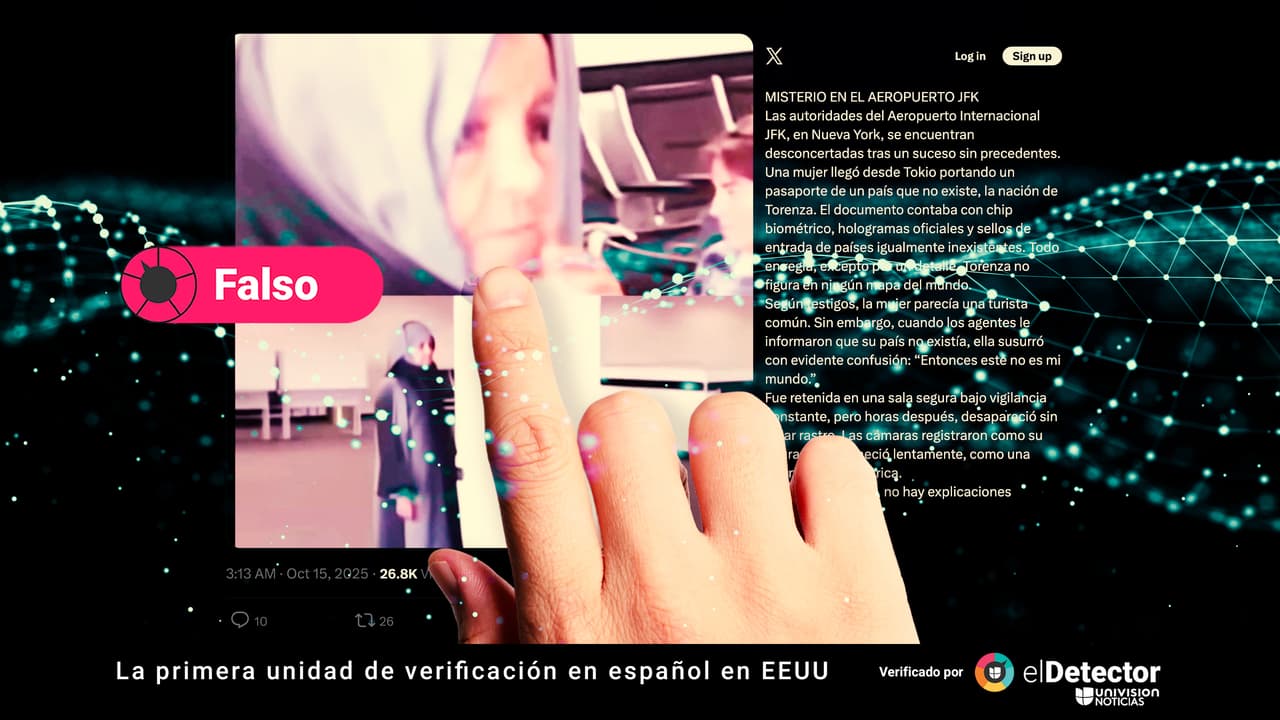

Cada vez son más los videos que parecen mostrar “realidades”, pero que han sido generados con inteligencia artificial (IA). Expertos consultados por elDetector y diferentes reportes alertan sobre los peligros de este contenido y las implicaciones éticas que se han generado.

Muchas de las afirmaciones sugieren que eso había ocurrido en el marco de las protestas en la capital de Illinois, para rechazar la militarización. Sin embargo, ni el joven enardecido, ni el “Sargento Pimienta” son reales. Fueron creados con Sora 2, la app hiperrealista para videos de OpenAI, los mismos creadores de ChatGPT.

“Los vídeos cada vez más realistas tienen más probabilidades de tener consecuencias en el mundo real al exacerbar conflictos, defraudar a los consumidores, manipular las elecciones o incriminar a personas por delitos que no cometieron”, advierte The New York Times .

¿Quieres verificar algo? Envíalo a nuestro chat de WhatsApp +1 (305) 447-2910 .

Un informe de NewsGuard, un programa que ayuda a empresas y consumidores a identificar información confiable en línea, reveló que la última versión de la herramienta de creación de videos de OpenAI, Sora 2, creó imágenes a partir de información falsa o engañosa el 80% de las veces en que se le hizo una solicitud, a pesar de los controles de la herramienta. Newsguard recalca que Sora ha generado preocupación por su capacidad de producir videos convincentes, incluidos supuestos reportajes periodísticos, que resultan ser deepfakes (creaciones generadas con inteligencia artificial) .

El peligro ético del hiperrealismo de las creaciones con IA

Otra escena: en un video que circula en Facebook y otras redes sociales se ve a un hombre vestido de negro bajar a rapel por un edificio, se produce un corte del video y posteriormente está dentro de la sala de lo que parece un museo, se ven obras de arte y también joyas, rompe un exhibidor de vidrio y saca un collar y cuando decide robar unos pendientes o zarcillos, se oye una alarma; el hombre corre y se ve escapando por los alrededores de la pirámide del Museo del Louvre. Afirman que es del momento del robo que sufrió el famoso museo el pasado 19 de octubre de 2025. Sin embargo, el video no es real, sino generado por Sora.

“Creo que desde que empezamos a tener modelos de imagen capaces de generar representaciones de personas reales en eventos en los que no participaron, de forma más creíble, podemos decir que la presunción automática de que una foto es real ya no debería existir. Esto ocurre desde hace más de un año. Los videos solían considerarse una prueba más sólida de que algo realmente había sucedido, pero eso también se está desvaneciendo. Por lo tanto, existe un riesgo evidente de una mayor proliferación de imágenes y videos falsos”, explicó vía correo electrónico a elDetector, el periodista, consultor de IA y profesor de la Institución de Educación Superior sin fines de lucro Insper, de Brasil, Pedro Burgos.

Pudiese parecer que los videos generados con IA tienen la mera finalidad de entretenimiento, o hacer referencia a algún hecho, pero hay detalles éticos en las creaciones que pueden generar daño, como, por ejemplo, los deepfakes que circularon sobre Martin Luther King Jr., que OpenAI tuvo que detener por irrespetuosos. Básicamente, estas creaciones mostraban al líder de los derechos civiles emitiendo expresiones racistas, en la edición de su famoso discurso “ Yo tengo un sueño” (1963, monumento a Lincoln, Washington) . El mismo problema se ha replicado con otras figuras históricas o artistas, a las que “reviven” en hechos que no existieron.

“Las personas tienden a creer lo que ven y, como tal, los videos de IA generativa que representan eventos falsos pueden ser especialmente convincentes, mucho más que antes”, dijo Mark Finlayson, profesor en la Escuela de Computación y Ciencias de la Información de la Fundación Knight en la Universidad Internacional de Florida (FIU, por sus siglas en inglés), a elDetector en un correo electrónico.

Un portavoz de OpenAI dijo a The New York Times que “la compañía había lanzado Sora como su propia aplicación para brindar a las personas un espacio dedicado para disfrutar de videos generados por IA y reconocer que los clips se hicieron con IA. La compañía también integró tecnología para hacer que los videos sean fáciles de rastrear hasta Sora, incluidas marcas de agua y datos almacenados dentro de los archivos de video que actúan como firmas”. Sin embargo, esto parece no ser suficiente, dados los resultados de informes y voces expertas.

Es por ello que el informe de Newsguard alerta de que “los cibercriminales pueden usar esta poderosa nueva tecnología como arma para difundir información falsa a gran escala”. El reporte destaca que con un mínimo de esfuerzo, los actores maliciosos pueden usar esta herramienta para hacer que las afirmaciones falsas sean más convincentes.

La duda siempre debe estar presente

“Hoy en día, cualquier video podría ser generado o manipulado por IA”, dijo Finlayson, por lo que insta a que los usuarios de redes sociales estén siempre atentos a los videos, imágenes o textos que reciben.

Tanto el profesor de la FIU como Burgos coinciden en que Sora 2 parece estar “perfeccionándose”, pero sigue teniendo elementos que hacen detectable que un video o grabación es una creación con IA y que también explicamos en elDetector.

- Texturas de piel sin detalles.

- Movimientos poco naturales.

- Audio desincronizado.

- Que aparecen o desaparecen personas u objetos sin explicación.

- Video no mayor a 10 segundos.

“Creo que lo más importante es contar con información contextual. Si aparece, por ejemplo, un video de un político o empresario haciendo algo, el usuario debe buscar otros registros de ese hecho. ¿La prensa estuvo allí? ¿Hay otras publicaciones en redes sociales sobre el evento que lo confirmen? La idea es tratar cualquier pieza audiovisual como insuficiente para probar algo”, agregó Burgos.

Finlayson alerta que “desafortunadamente los sistemas seguirán mejorando, por lo que estas señales eventualmente desaparecerán”, e insiste en que se verifique la información presentada con “organizaciones externas confiables que mantengan una alta integridad periodística”. Lee aquí cómo escogemos y asignamos nuestras etiquetas en elDetector.

elDetector opera de forma independiente con el financiamiento de instituciones que puedes ver aquí y que no tienen ningún poder de decisión sobre nuestro contenido. Nuestra línea editorial es autónoma.

¿Viste algún error o imprecisión? Escríbenos a eldetector@univision.net o a través de nuestra cuenta de X (Twitter) @eldetectoruni. Tras verificar tu solicitud, haremos la corrección que corresponda en un plazo no mayor de 48 horas.

Lee aquí nuestra metodología y política de corrección. Seguimos el Código de Principios de la International Fact-Checking Network (IFCN), que puedes ver aquí traducido al español. Escribe a la IFCN llenando este formulario si consideras que no estamos cumpliendo ese código.

Envíanos al chat de WhatsApp +1 (305) 447-2910 lo que quieras que verifiquemos.